1. 人类与战争法的适应问题

如果那些原本由人类执行的功能现在由机器完成,这将引发一系列问题,最关键的问题是:现行的战争法是否仍然适用?因为这些法律是为人类制定的,而不是为机器。

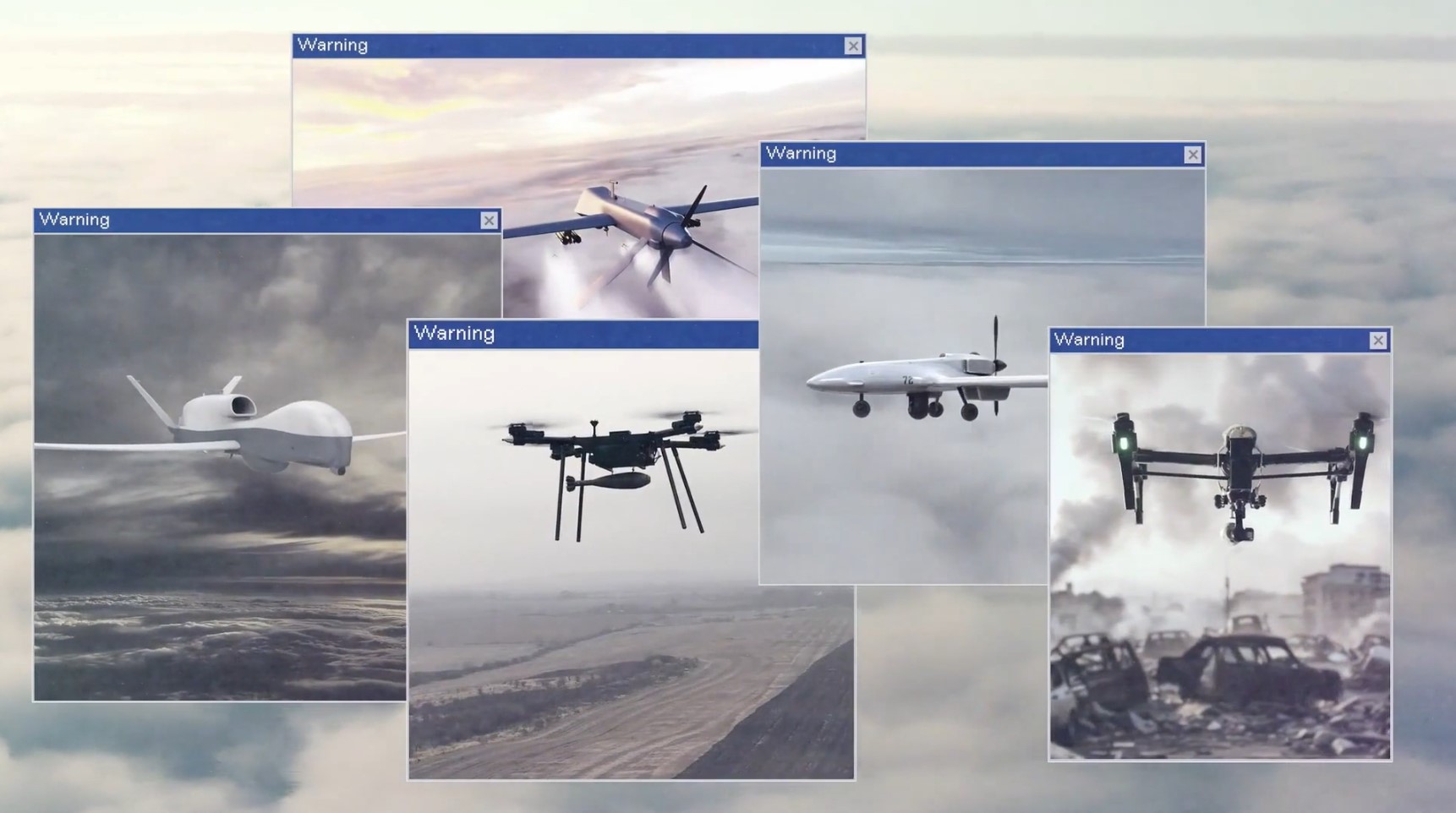

2. 什么是致命性自主武器?

技术的发展使得自主武器系统的出现成为可能。这些系统一旦启动,便能够自行搜索、选择并攻击目标个体,完全不需要人类进一步干预。这样会带来一系列严重问题,比如:

- 我们可能无法追踪这些系统的部署者;

- 即使知道来源,也可能无法追责;

- 可能造成严重后果却无人负责,只能说“是机器做的”。

当机器被完全授权作出生死决策,使用致命武力时,就会出现一个责任极为模糊的灰色地带:谁应当负责?

3. AI武器与决策失误的风险

我们知道技术并不完美,它会犯错。日常生活中我们或许可以容忍技术出错,但在战场上,一个错误可能意味着生死。

自动武器系统可能错误识别目标,尤其在依赖传感器和AI时。当前AI仍存在严重缺陷,却已经被应用于武器系统。这些系统还可能带有程序员的偏见,后果可能对人类灾难性。

4. 道德与法律问题

让机器决定是否杀死一个人,这在道德上是极其令人反感的。联合国的立场是:这种行为应被国际法禁止。自主性,特别是在无人机上的应用,是一个重大问题。

5. 国际人道法的挑战

根据国际人道法,只有在直接参与敌对行动的人或特定武装力量成员才可以被合法攻击。问题在于:

- 自主系统是否能准确识别合法目标?

- 在快速变化、复杂的战场环境中,机器是否能做出保护平民的决策?

- 它们能否快速分析战斗人员与平民的区别?

使用致命武力的法律框架基于“人类负责”,但机器或算法无法被追责。现有法律适用于所有武器系统,其核心原则是保护非战斗人员,我们必须维护并加强这一点。

6. 呼吁建立新框架:禁止与监管

我们需要明确的新国际规则来应对自主武器系统,并为未来带来的问题建立应对机制。目前没有任何国际框架来监管这类武器,而这是迫切需要的,不是未来几十年内,而是未来几年内就必须建立。

7. 紧迫的全球问题

如果不加以监管和控制,这将变成一个关乎人类生存的问题。目前我们还处于AI武器发展的初期阶段,因此相关讨论与谈判需要紧迫进行。在完全自主、无人监管、无人负责的武器成为“首选”之前,我们必须防止其带来的不可预测影响。